Ich glaub, mich laust der Affe: Ausgerechnet im manisch sensitiven Null-Toleranz-für-Rassismus-Elysium Facebook, diesem Gutmenschentümpel mit erbarmungslosen “Gemeinschaftsstandards”, der bei jedem Hauch von Befindlichkeitsstrapaze in Lösch- und Zensurterror verfällt, gibt es nun einen handfesten Skandal von ECHTEM Rassismus. Und für den sorgen ausgerechnet dieselben Algorithmen, mit denen das Netzwerk sonst seine Zuordnungen trifft.

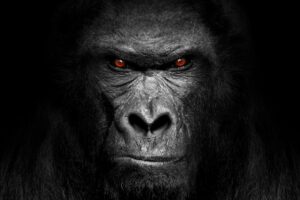

Gewissermaßen mit den eigenen Waffen geschlagen wurde nun ein monströses KI-System, das seine Datenauswertungs-Kompetenz für allmächtig hält: Ein Facebook-Algorithmus hat nämlich in schwarzen Menschen offenkundig Affen erkannt. Die “Frankfurter Allgemeine Zeitung” (FAZ) berichtet, eine Zuckerberg-Sprecherin habe das Problem, das zuerst nach Veröffentlichung eines Videos des britischen Boulevard-Blatts “Daily Mail” aufgetreten war, das den Titel trug “Weißer Mann ruft Polizei wegen schwarzen Männern am Hafen”. Alleine diese Formulierung zeugt bereits von einer woke-infizierten, BLM-angestoßenen, krankhaften Fixierung auf die Hautfarbe, die ihrerseits vor Rassismus nur so sprüht.

Den Vogel ab schoss dann aber die von Facebook automatisch eingespielte Frage an die Zuschauer, ob diese “weiterhin Videos über Primaten sehen möchten”. Die Gesichtserkennungssoftware von Facebook hat hier also ganze Arbeit geleistet. Ein “eindeutig inakzeptabler Fehler“, zitiert die FAZ die Facebook-Sprecherin.

Offenbarungseid für die Facebook-KI

Es ist noch mehr: Ein Offenbarungseid für Facebooks angeblich hocheffiziente “Personalisierung von Inhalten” durch Künstliche Intelligenz, die auch bei Werbeeinspielungen auf der Seite zum Einsatz kommt – und in Wahrheit eben eines nicht ist, nämlich intelligent. Das Unternehmen ging mittlerweile in Sack und Asche und entschuldigt sich “bei jedem, der diese beleidigen Empfehlungen gesehen hat“, so die “New York Times“.

Eigentlich sollte der Vorgang Facebook zu denken geben: Denn wenn bereits bei solchen hochsensiblen und brisanten Inhalten die eigene Software versagt, wie ungenau ist sie dann erst bei der Aussiebung von “Fake-News”, von “Hassrede”, von Beiträgen mit “extremistischer” Gesinnung oder “gruppenbezogener Menschenfeindlichkeit”? Die, die von den täglichen Resultaten dieser automatisierten Zensur tagtäglich betroffen sind, können davon ein Lied singen. Doch weil Regierungen und Aktivisten Big-Tech animieren, belogen oder sogar strafbewehrt verpflichten, im Zweifel besser zuviel als zuwenig zu löschen, wird diese Unschärfe bewusst toleriert. Diesmal wurde sie zum Bumerang. (DM)